반응형

mnasnet, 셔플넷

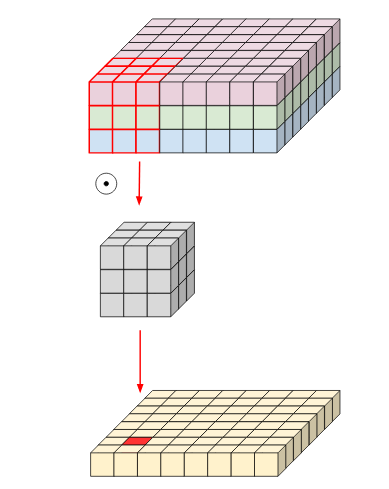

기존 컨볼루션

모바일넷 v1에서 제안된 depth-wise, point-wise 컨볼루션(separable convolution)

입력: h*w*d(d는 채널수)

커널: k*k*d*d'(d'는 필터수)

기존 연산량: h*w*d*k*k*d'

separable 연산량: h*w*d*(k^2+d')

1/d'+1/(k^2) 보통 1/8, 1/9 수준으로 줄어들음

Width multiplier: 채널을 일정한 비율로 줄이기

resolution mutilplier: 이미지 크기를 일정 수준으로 줄이기

v2

separable

linear bottleneck layer

relu 쓰면 성능 떨어짐

inverted resudual blocks

기존 residual

inverted residual block : 메모리 효율이 많음

bottleneck residual block

기존 연산량: h*w*d*k*k*d'

separable 연산량: h*w*d*(k^2+d')

v2 연산량: h*w*d*t*(k^2+d'+d") where t=expansion factor, d" output channel, d': input ch

실제로 연산량 60프로 수준임

나스넷, 셔플넷에 비하면 근소하게 좋음.

반응형

'머신러닝 읽어주는 남자' 카테고리의 다른 글

| 코로나 데이터 분석 (0) | 2020.03.22 |

|---|---|

| [코로나 예측/예상]인공지능이 예상한 코로나 바이러스(COVID-19) (0) | 2020.03.22 |

| tf.data.dataset (0) | 2020.03.19 |

| 인공지능(딥러닝) 입문 추천 (0) | 2020.03.15 |

| tensorflow example, tfrecord (0) | 2020.03.13 |